大幅减轻医生负担!人工智能用于电子医疗记录虽好,但专家发现了这五个重大危险

时间:2025-01-21 12:13:11 热度:37.1℃ 作者:网络

病历是患者就诊过程最重要的记录,也是医生、尤其是内科住院医师负担突出的工作量。

尤其是在所有信息都电子化的当下,医生在临床工作中花费了大量时间进行电子健康记录(EHR)的编写和阅读,这不仅影响了医生的工作效率,还可能导致职业倦怠和医疗服务质量的下降。

但实际上,病历就是医生记录下来了所见及查体所得,对于病例的分析和思考。大型语言模型(LLM)的发展,能否被应用于生成EHR?

为了解决这一问题,大型语言模型(LLM)如OpenAI的GPT-4和Google的Gemini被率先应用于生成EHR文档,结果显示:大幅减轻了医生的工作负担【1】。

然而,医疗过程的严格要求,也使得这个应用在初期面临很多需要调整的问题;如降低医疗记录的质量和效率,以及影响临床推理和决策。

因此,研究LLM在EHR中的应用及其潜在风险具有重要意义【2】。Liam G. McCoy 在 The New England Journal of Medicine 杂志年度回顾专栏上发表了题为 Large Language Models and the Degradation of the Medical Record 的文章,对AI进行电子记录中出现的问题进行了回顾和总结【3】。

AI进行电子医疗记录时,最常出现的问题

🔷 信息质量下降:

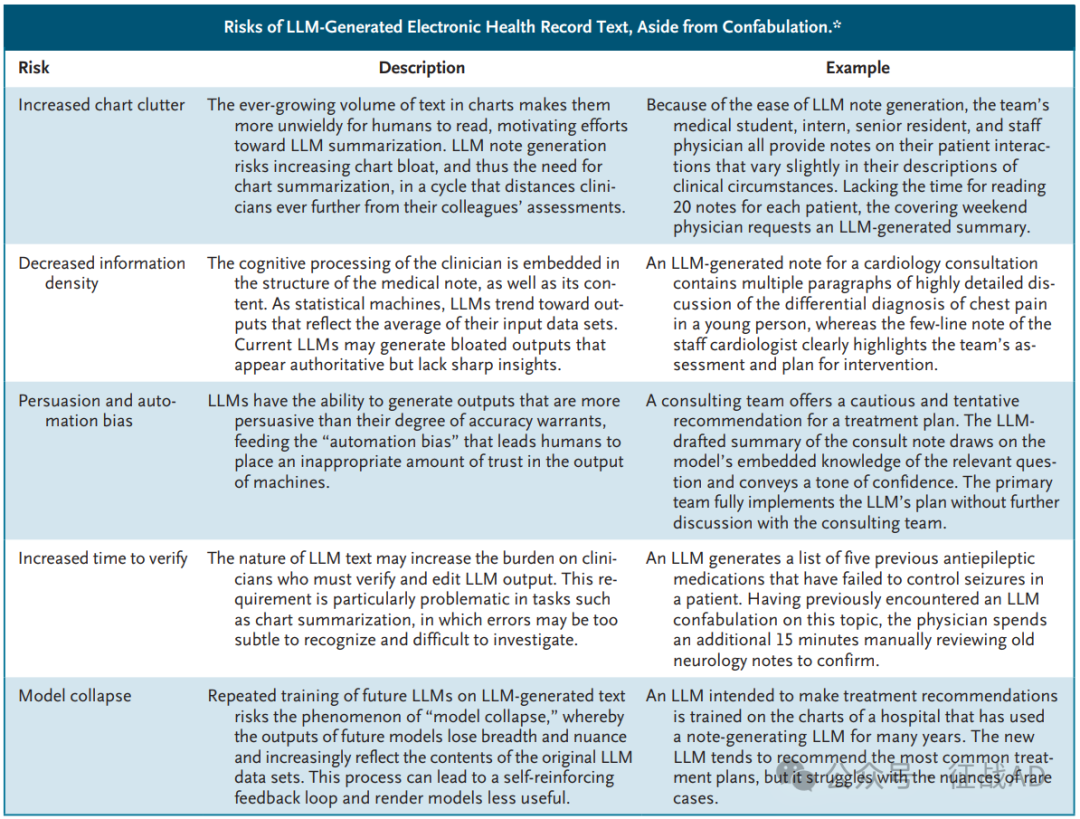

LLM生成的文本可能包含错误信息或缺乏深度见解,导致EHR的准确性降低。

例如,LLM生成的笔记可能过于冗长且缺乏关键的临床洞察,从而使得医疗记录对医生和未来AI模型的实用性降低.

🔷 临床推理受损:

LLM生成的文档可能削弱医生的临床推理能力。文档编写过程本身是临床推理的重要组成部分,选择哪些信息纳入文档以及如何总结临床印象都需要医生进行深入的思考和判断。如果这些任务由LLM完成,可能会导致医生的临床推理能力得不到充分锻炼和提升.

🔷 未来AI模型发展受限:

如果EHR中充斥着LLM生成的低质量文本,未来AI模型的训练和应用将受到限制。

LLM的训练依赖于高质量的数据输入,如果输入数据质量下降,可能导致模型输出的广度和深度下降,形成一个自我强化的负面反馈循环,使得模型越来越难以提供有价值的临床决策支持.

🔷 EHR现状固化:

LLM的整合可能导致EHR系统的现状被固化,而不是推动其向更高效、更人性化的方向发展。EHR系统的早期设计存在一些缺陷,如缺乏协作编辑功能和超链接等“数字优先”特性。如果LLM的应用仅仅是在现有系统框架内进行,而没有推动系统架构的创新和优化,可能会进一步限制EHR在临床实践中的应用效果。

🔷 AI幻觉:

ChatGPT一经推出我们就开始应用其付费功能,并发现了GPT经常一本正经地胡说八道(AI幻觉),并产生和输出一些不存在的问题。

出现在EHR中的AI幻觉显然可能会是对患者的致命伤害。

除了虚构之外,LLM 生成 EHR 的风险

编者按:

临床意义:

本文章提醒医生和科学家在应用人工智能大语言模型生成电子医疗记录(EHR)文档时需谨慎,应充分评估其对医疗记录质量和临床推理的影响。

尤其是,医生作为第一责任人,需要仔细核对AI生成的文本。

和科研启示:

人工智能高速发展,广泛应用于临床的过程不可逆转。

未来的研究可以探索如何更好地结合LLM和EHR,以提高医疗记录的质量和效率,同时保留临床推理和个性化医疗的优势。

此外,研究者还可以关注如何改进EHR系统的设计,使其更好地支持临床决策和患者护理。

其实目前最有应用场景的临床科研题目是,应用AI读取电子医疗记录,从而生成总结性报告。由此对于疑难病的诊断、临床医生忽略的问题、诊断的方向等产生重要的启发。

References:

【1】 https://medcitynews.com/2025/01/from-paper-charts-to-ai-scribes-the-ehr-revolution/

【2】Shumailov I, Shumaylov Z, Zhao Y, Papernot N, Anderson R, Gal Y. AI models collapse when trained on recursively generated data. Nature 2024;631:755-759.

【3】DOI: 10.1056/NEJMp2405999